Введение в MLOps: Автоматизация жизненного цикла моделей машинного обучения

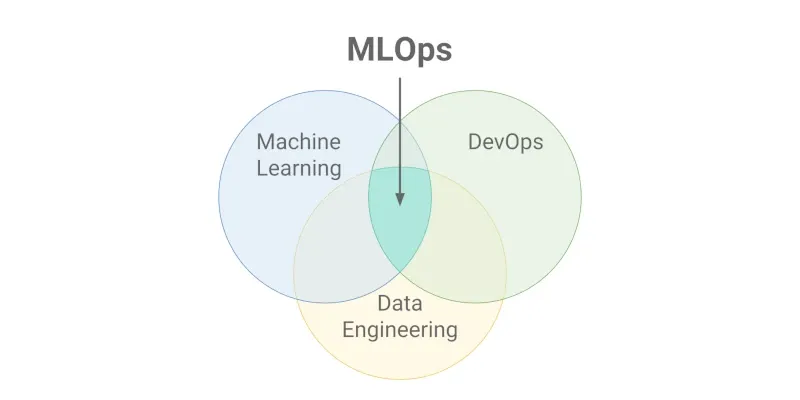

В эпоху стремительного развития искусственного интеллекта создание модели машинного обучения — это лишь начало пути. Настоящая ценность раскрывается только тогда, когда модель успешно развернута в продакшене, работает стабильно и непрерывно улучшается. Именно здесь на помощь приходит MLOps — дисциплина, которая объединяет принципы DevOps с уникальными требованиями машинного обучения.

Что такое MLOps?

MLOps (Machine Learning Operations) — это набор практик, инструментов и методологий для автоматизации и оптимизации жизненного цикла моделей машинного обучения. Это мост между разработкой ML-моделей и их эксплуатацией в реальных условиях.

В отличие от традиционного программного обеспечения, ML-системы имеют дополнительную сложность — они зависят не только от кода, но и от данных, которые постоянно изменяются. Модель, которая показывала отличные результаты месяц назад, может деградировать из-за изменений в данных или их распределении.

Почему MLOps критически важен?

Проблемы без MLOps

Без систематического подхода к управлению ML-моделями организации сталкиваются с множеством проблем:

- Модели остаются в экспериментах: по данным исследований, только 20-30% ML-проектов доходят до продакшена

- Отсутствие воспроизводимости: невозможно точно повторить результаты эксперимента через несколько месяцев

- Незамеченная деградация моделей: модели теряют точность, но никто об этом не знает

- Медленная итерация: обновление модели занимает недели или месяцы

- Операционные риски: отсутствие откатов, мониторинга и алертинга

Преимущества MLOps

Внедрение MLOps решает эти проблемы и приносит ощутимые выгоды:

- Ускорение time-to-market: автоматизация позволяет развертывать модели в разы быстрее

- Повышение надежности: систематический мониторинг и тестирование снижают риски

- Масштабируемость: возможность управлять сотнями моделей одновременно

- Compliance и аудит: полная отслеживаемость экспериментов и решений

Основные компоненты MLOps

1. CI/CD для Machine Learning

Непрерывная интеграция и непрерывная доставка в ML имеют свои особенности по сравнению с традиционной разработкой ПО.

Особенности ML CI/CD:

Многоуровневое тестирование:

- Тестирование кода (unit tests, integration tests)

- Валидация данных (schema validation, drift detection)

- Тестирование модели (accuracy tests, performance tests)

- Инфраструктурные тесты

Триггеры для развертывания:

- Изменения в коде

- Новые данные

- Деградация модели в продакшене

- Переобучение по расписанию

Пример пайплайна CI/CD:

# Пример GitHub Actions для ML проекта

name: ML Pipeline

on:

push:

branches: [main]

schedule:

- cron: '0 2 * * *' # Ежедневная переподготовка

jobs:

data-validation:

runs-on: ubuntu-latest

steps:

- name: Validate data schema

- name: Check for data drift

- name: Quality checks

model-training:

needs: data-validation

steps:

- name: Train model

- name: Validate model performance

- name: Compare with baseline

model-deployment:

needs: model-training

steps:

- name: Deploy to staging

- name: Run integration tests

- name: Deploy to production2. Мониторинг моделей

Мониторинг в ML выходит далеко за рамки традиционных метрик производительности системы.

Типы мониторинга:

Data Drift мониторинг: Отслеживание изменений в распределении входных данных. Если данные, поступающие в модель, кардинально отличаются от обучающих, качество предсказаний может ухудшиться.

# Пример детекции drift с помощью статистических тестов

from scipy import stats

def detect_drift(reference_data, current_data, threshold=0.05):

statistic, p_value = stats.ks_2samp(reference_data, current_data)

return p_value < threshold # True если есть driftModel Performance мониторинг:

- Accuracy, precision, recall в реальном времени

- Латентность предсказаний

- Throughput системы

Business Metrics мониторинг:

- Влияние модели на ключевые бизнес-метрики

- ROI от использования ML

Алертинг и автоматические действия:

# Пример автоматического переобучения

if model_accuracy < threshold:

trigger_retraining_pipeline()

send_alert_to_team()

if data_drift_detected:

flag_for_manual_review()

consider_model_update()3. Управление данными

Данные — основа любой ML-модели, и управление ими требует особого внимания.

Ключевые аспекты:

Версионирование данных: Как и код, данные должны версионироваться для обеспечения воспроизводимости экспериментов.

Качество данных:

- Автоматические проверки полноты данных

- Валидация схемы данных

- Детекция аномалий

Lineage данных: Отслеживание происхождения данных от источника до модели.

Пример системы управления данными:

# Пример с DVC

import dvc.api

# Получение конкретной версии данных

data = dvc.api.get_url(

path='data/train.csv',

repo='https://github.com/example/ml-project',

rev='v1.2.0' # Конкретная версия

)

# Валидация данных

def validate_data_quality(data):

checks = [

check_completeness(data),

check_schema_compliance(data),

check_value_ranges(data)

]

return all(checks)Популярные инструменты MLOps

Kubeflow: Платформа для ML на Kubernetes

Kubeflow — это открытая платформа для развертывания, мониторинга и управления ML-воркфлоу на Kubernetes.

Основные компоненты:

Kubeflow Pipelines: Позволяет создавать и управлять воспроизводимыми ML-пайплайнами.

# Пример Kubeflow Pipeline

from kfp import dsl

@dsl.pipeline(

name='ML Training Pipeline',

description='End-to-end ML pipeline'

)

def ml_pipeline(

data_path: str = '/data/input',

model_name: str = 'my_model'

):

# Компонент подготовки данных

prep_data = dsl.ContainerOp(

name='prepare-data',

image='my-repo/data-prep:latest',

arguments=['--input', data_path]

)

# Компонент обучения

train_model = dsl.ContainerOp(

name='train-model',

image='my-repo/trainer:latest',

arguments=['--data', prep_data.outputs['output']]

)

# Компонент оценки

evaluate_model = dsl.ContainerOp(

name='evaluate',

image='my-repo/evaluator:latest',

arguments=['--model', train_model.outputs['model']]

)KFServing (теперь KServe): Обеспечивает серверные возможности для развертывания моделей с автомасштабированием и A/B тестированием.

Преимущества Kubeflow:

- Масштабируемость благодаря Kubernetes

- Поддержка различных ML-фреймворков

- Встроенные возможности мониторинга

- Управление ресурсами

MLflow: Платформа для управления ML жизненным циклом

MLflow — это открытая платформа для управления полным жизненным циклом ML, включая эксперименты, воспроизводимость и развертывание.

Компоненты MLflow:

MLflow Tracking: Логирование и отслеживание экспериментов.

import mlflow

import mlflow.sklearn

from sklearn.ensemble import RandomForestRegressor

from sklearn.metrics import mean_squared_error

# Начало эксперимента

with mlflow.start_run():

# Параметры модели

n_estimators = 100

max_depth = 10

# Логирование параметров

mlflow.log_param("n_estimators", n_estimators)

mlflow.log_param("max_depth", max_depth)

# Обучение модели

model = RandomForestRegressor(

n_estimators=n_estimators,

max_depth=max_depth

)

model.fit(X_train, y_train)

# Предсказания и метрики

predictions = model.predict(X_test)

mse = mean_squared_error(y_test, predictions)

# Логирование метрик

mlflow.log_metric("mse", mse)

# Сохранение модели

mlflow.sklearn.log_model(model, "random_forest_model")MLflow Models: Стандартизированный формат для упаковки ML-моделей.

MLflow Model Registry: Централизованное хранилище моделей с версионированием и управлением жизненным циклом.

# Регистрация модели

model_name = "my_model"

mlflow.register_model(

model_uri=f"runs:/{run_id}/random_forest_model",

name=model_name

)

# Перевод модели в стадию Production

client = mlflow.MlflowClient()

client.transition_model_version_stage(

name=model_name,

version=1,

stage="Production"

)DVC: Система версионирования данных и моделей

DVC (Data Version Control) — это инструмент для версионирования данных и ML-моделей, который интегрируется с Git.

Основные возможности:

Версионирование больших файлов:

# Добавление данных под версионный контроль

dvc add data/large_dataset.csv

# Коммит изменений

git add data/large_dataset.csv.dvc .gitignore

git commit -m "Add dataset v1.0"

# Создание тега

git tag -a "v1.0" -m "Dataset version 1.0"Пайплайны данных:

# dvc.yaml - описание пайплайна

stages:

prepare_data:

cmd: python prepare_data.py

deps:

- prepare_data.py

- data/raw

outs:

- data/prepared

train:

cmd: python train.py

deps:

- train.py

- data/prepared

outs:

- models/model.pkl

metrics:

- metrics.json

evaluate:

cmd: python evaluate.py

deps:

- evaluate.py

- models/model.pkl

- data/test

metrics:

- evaluation.jsonЗапуск пайплайна:

# Выполнение всего пайплайна

dvc repro

# Просмотр метрик

dvc metrics show

# Сравнение экспериментов

dvc exp showПреимущества DVC:

- Легкая интеграция с существующими Git-репозиториями

- Поддержка различных хранилищ (S3, GCS, Azure, etc.)

- Воспроизводимые пайплайны

- Сравнение экспериментов

Внедрение MLOps: пошаговый подход

Этап 1: Оценка текущего состояния

Проведите аудит существующих ML-процессов:

- Как происходит обучение моделей?

- Где хранятся данные и артефакты?

- Как модели попадают в продакшен?

- Есть ли мониторинг работы моделей?

Этап 2: Начните с основ

Версионирование:

- Начните версионировать код, данные и модели

- Внедрите DVC для управления артефактами

Эксперимент трекинг:

- Используйте MLflow для логирования экспериментов

- Создайте центральный реестр моделей

Этап 3: Автоматизация

CI/CD пайплайны:

- Автоматизируйте тестирование кода и данных

- Внедрите автоматическое развертывание

Мониторинг:

- Настройте мониторинг производительности моделей

- Внедрите детекцию drift’а данных

Этап 4: Масштабирование

Платформенный подход:

- Рассмотрите внедрение Kubeflow или аналогичных платформ

- Стандартизируйте процессы для всех команд

Заключение

MLOps — это не просто набор инструментов, а культурный сдвиг в подходе к разработке ML-систем. Он позволяет организациям превратить машинное обучение из экспериментальной деятельности в надежный, масштабируемый и управляемый процесс.

Ключевые принципы успешного MLOps:

- Автоматизация — минимизируйте ручной труд везде, где это возможно

- Мониторинг — что нельзя измерить, нельзя улучшить

- Воспроизводимость — каждый эксперимент должен быть повторяем

- Сотрудничество — разрушьте барьеры между командами

- Непрерывное улучшение — MLOps сам должен эволюционировать

Начинайте внедрение MLOps постепенно, с решения самых критичных проблем вашей организации. Помните: лучший MLOps — это тот, который реально используется командой, а не самый технически совершенный.

Инвестиции в MLOps окупаются многократно через ускорение разработки, повышение надежности и возможность масштабирования ML-решений на всю организацию.